经常会被一些网络恶意垃圾蜘蛛或网络爬虫骚扰,导致自己的流量整天被刷,有的更夸张的是每天被几十个垃圾爬虫和蜘蛛不断刷自己流量,直接导致网站宕机都有可能出现。下面虾皮路就分享一下屏蔽恶意垃圾蜘蛛爬虫从而加速网站访问,保护网站不被恶意刷流量。

常见的网络恶意垃圾爬虫蜘蛛

1、MJ12Bot

MJ12Bot 是英国著名SEO公司Majestic的网络爬虫,其抓取网页给需要做SEO的人用,不会给网站带来流量。

2、AhrefsBot

AhrefsBot 是知名SEO公司Ahrefs的网页爬虫。其同样抓取网页给SEO专业人士用,不会给网站带来流量。

3、SEMrushBot

SEMrushBot 也是SEO、营销公司的网络爬虫。

4、DotBot

DotBot 是 Moz.com 的网页爬虫,抓取数据用来支持 Moz tools 等工具。

5、MauiBot

MauiBot 不同于其他爬虫,这个爬虫连网站都没有,UA只显示一个邮箱:”MauiBot (crawler.feedback+wc@gm ail.com)“。神奇的是这个看起来是个人爬虫,竟然遵循robots协议,算得上垃圾爬虫的一股清流。

6、MegaIndex.ru

这是一个提供反向链接查询的网站的蜘蛛,因此它爬网站主要是分析链接,并没有什么作用。遵循robots协议。

7、BLEXBot

这个是webmeup下面的蜘蛛,作用是收集网站上面的链接,对我们来说并没有用处。遵循robots协议。

屏蔽/禁止恶意垃圾蜘蛛爬虫方法

屏蔽垃圾爬虫主要从两方面入手:1. robots.txt禁止;2. web层面通过UA禁止。

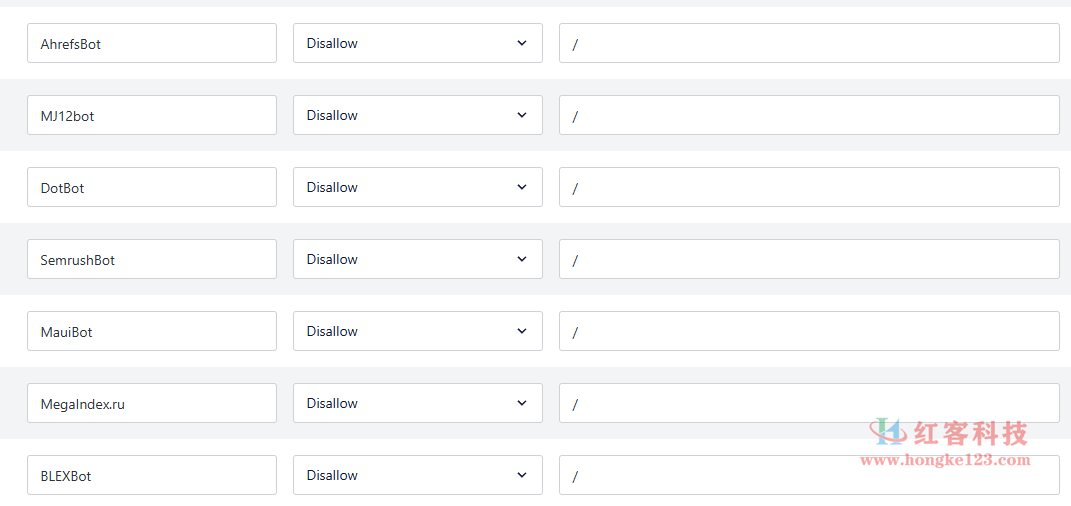

1、通过robots.txt禁止

对于遵循robots协议的蜘蛛,可以直接在robots禁止。上面常见的无用蜘蛛禁止方法如下,将下面的内容加入到网站根目录下面的robots.txt就可以了。常见的一些屏蔽恶意蜘蛛代码如下,也可以根据自己需要进行增减。

User-agent: SemrushBot

Disallow: /

User-agent: DotBot

Disallow: /

User-agent: MegaIndex.ru

Disallow: /

User-agent: MauiBot

Disallow: /

User-agent: AhrefsBot

Disallow: /

User-agent: MJ12bot

Disallow: /

User-agent: BLEXBot

Disallow: /

web层面通过UA禁止

对于不遵循robots协议的爬虫,可以在web软件层面通过UA屏蔽。

同时网站可以使用cdn进行加速!

CDN的工作原理就是将源站的资源缓存到位于全国各地的CDN节点上,用户请求资源时,就近返回节点上缓存的资源,而不需要每个用户的请求都回您的源站获取,避免网络拥塞、分担源站压力,保证用户访问资源的速度和体验。